Exploration des MCPs

Les cimetières sont remplis de sociétés qui n’ont pas compris les règles du jeu.

Les tarifs sont la préoccupation première dans les médias aujourd’hui et on essaie de déchiffrer les derniers propos de Donald Trump, Scott Bessent ou Howard Lutnick. Peine perdue…Il vaut mieux continuer à suivre les avancées de l’IA qui auront probablement un impact structurel bien supérieur sur l’économie que les propos du jour, blancs ou noirs selon l’heure…

En consultant le chatbot Qwen (Alibaba), je suis tombé sur cet écran:

La mention MCP (bientôt), accompagnée d’étoiles prometteuses a éveillé ma curiosité. Quel produit miracle va nous proposer Qwen prochainement ? Cela m’a semblé d’autant plus notable qu’aucune version gratuite des grands LLMs ne propose de MCP aujourd’hui. Après DeepSeek, la Chine aurait-elle encore un coup d’avance ?

Qu’est-ce que le protocole MCP ?

MCP (Model Context Protocol) est un protocole standard (ensemble de règles et conventions) permettant de faire communiquer un chatbot et un programme exécutant des actions. Il transforme le chatbot en agent sans travail d’intégration excessif. Ce chatbot peut être un dérivé de LLama ou Claude par exemple et le programme peut être une application comme Uber, Slack, Gmail ou un nouveau programme. Le protocole MCP pour l’IA est l’équivalent pour l’alimentation électrique d’une prise USB-C qui permet de connecter n’importe quel gadget électronique à un chargeur électrique: le MCP a pour fonction de connecter n’importe quel chatbot à n’importe quelle application. Il constitue un langage commun compris à la fois par le chatbot et l’application, en vue d’une action dans l’application et d’une réponse donnée dans le chatbot. Au lieu de régurgiter des phrases, le chatbot exécute ce qu’on lui dit de faire ! L’avantage de standardiser le noeud de communication est d’augmenter considérablement l’effet d’échelle aux deux bouts de la chaîne, le chatbot et l’application finale.

Le protocole MCP fonctionne selon une architecture client/serveur déjà bien rodée: le client (matériel ou logiciel) envoie des requêtes pour accéder à des services, données ou ressources; le serveur (matériel ou logiciel) reçoit ces requêtes, les traite puis renvoie une réponse (services, données ou ressources) au client. Le client est décentralisé (par exemple navigateur Chrome qui fait la requête) et le serveur centralisé (par exemple serveur Google qui renvoie la réponse). L’avantage de cette architecture est de faciliter la maintenance (tout est centralisé sur le serveur), sécuriser les données (sur le serveur) et de mutualiser les ressources entre plusieurs clients. Le rapport qualité/prix est imbattable.

Dans notre cas, il y a un hôte, l’interface que vous utilisez (Claude, Qwen, etc.). Cet hôte crée un client MCP qui est une instance logicielle qui va envoyer les requêtes à un serveur MCP et réceptionner ses réponses. Ces requêtes sont des messages structurés créés par le client MCP à partir de vos prompts, destinés à exécuter des actions avec les ressources, outils ou prompts standards mis à disposition par le serveur MCP. Qu’est-ce donc que le serveur MCP à l’autre bout du fil ? C’est une passerelle connectée à une application, qui va recevoir de cette application la capacité de la faire travailler à partir d’outils, ressources ou prompts. Il y a à ce jour déjà de nombreux serveurs MCP pour gérer des fichiers, la messagerie, les cartes géographiques, la recherche sur internet, les réseaux sociaux, etc. L’avantage est que ces serveurs peuvent facilement se connecter à tel ou tel modèle d’IA qui le souhaitera. Il suffira à ce modèle de créer un client. Voici un schéma explicatif simple:

L’utilisateur ne participe pas à cette cuisine. Il peut simplement demander à son modèle d’effectuer des actions pour son compte au lieu d’avoir à naviguer lui même dans des applications. Le tableau suivant explique l’étymologie du protocole MCP:

Contrer OpenAI

Dans ses premières versions, ChatGPT était essentiellement un modèle régurgitant du texte, sur la base d’un entrainement figé dans le temps. Le chatbot était déconnecté de l’actualité et sa source de connaissance était limitée à l’information publique (4 % à 10 % des pages web mais moins de 0,1% du volume total des données). Une solution pour améliorer la qualité des réponses a été de donner au modèle, la capacité d’incorporer des textes privés à sa base d’entrainement. C’est ainsi que s’est développée la technique du RAG (Retrieval And Generation), largement utilisée par exemple pour ajouter une dimension recherche au modèle initial (ChatGPT Search par exemple). De même, les entreprises ont appris à connecter des modèles sur leurs données par l’intermédiaire d’un RAG. Les modèles étaient encore alors limités à la création de texte (effet de style) ou recherche d’information. Puis OpenAI a inventé les GPTs qui pouvaient spécialiser ChatGPT dans tel ou tel domaine: le design avec Canva, le calcul avec Wolfram Alpha, l’organisation de voyages avec Expedia, etc. Les GPTs permettaient de converser avec des applications et ainsi de spécialiser la conversation. Imitant Apple quelques années avant lui, OpenAI a imaginé de créer un magasin d’applications avec l’objectif de cimenter son effet réseau: plus d’applications partenaires renforce le magasin qui dès lors attire d’avantage d’applications. Les utilisateurs vont généralement là où le choix est le plus grand. L’App Store est ce qui a permis à Apple d’atteindre une capitalisation boursière de $3 trillions ($4 trillions au plus haut).

Anthropic, le concurrent d’OpenAI a vu la menace et l’a rapidement contrée. En novembre 2024, il a lancé le protocole MCP. A la différence de Google (Android), il ne s’est pas contenté d’une simple alternative open source au magasin de GPTs lancé par OpenAI. Anthropic a rendu possible la création et la multiplication d’agents indépendants grâce à la standardisation apportée par le protocole MCP. Il a ainsi tué dans l’oeuf la recette d’Apple pour capter le marché des développeurs. OpenAI ne peut plus l’employer et est dépassé dès le départ sur le marché des agents. Un serveur MCP est bien plus intéressant qu’un “plug in” GPT car au lieu de renvoyer une simple réponse écrite, il effectue une action dictée par l’utilisateur (une réservation, une recherche profonde ou autre dictée par le client MCP). Dès lors, le magasin des GPTs est rendu obsolète. Mais Anthropic ne s’approprie pas le protocole MCP, donnant ainsi au marché des agents un potentiel énorme: tout développeur peut créer un client MCP et/ ou un serveur MCP, à partir de n’importe quel modèle. Le standard ouvre le champ des possibles aux développeurs. Il y a aujourd’hui plus de 10 000 serveurs et clients MCP répertoriés couvrant une large gamme de services et d’intégration, allant de l’accès à des bases de données comme PostgreSQL et Redis, à des outils de développement tels que Github et Figma, en passant par des services de navigation comme Google Maps et des plateformes de communication comme Slack. Ce n’est qu’un début car la connexion d’un modèle à un serveur MCP n’est pas encore organisée et ressort du cas pas cas. Par exemple le serveur MCP Linkup propose de créer un concurrent à Deep Research de Perplexity ou OpenAI. Pour ce faire, il faut effectuer les manipulations suivantes:

Connectez-vous à Claude Desktop

Ouvrez Linkup et connectez votre compte

Cliquez sur Autoriser pour cette discussion lorsqu’on vous le demande

Linkup facilite la connexion de son serveur “deep web search” au client MCP Claude. Si en revanche, un développeur souhaite le connecter à un autre client MCP, il lui faut faire une configuration. Tout ceci n’est pas encore “plug and play”.

Du standard au magasin de serveurs et clients MCP

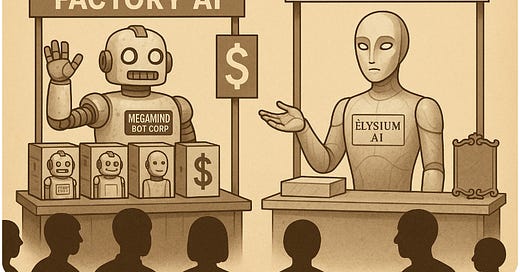

La décentralisation ne dure jamais très longtemps ! cf l’internet et les Big Tech. La facilité, c’est à dire l’accès un point de distribution unique est très attractif pour un utilisateur. Naviguer dans une jungle de propositions sans tri pertinent devient vite rébarbatif et chronophage. Il est probable qu’on arrive pour les MCP à une lutte pour constituer le point de distribution privilégié, l’endroit où l’on peut se connecter facilement à une multitude d’agents IA faisant le travail à notre place. Il y a aujourd’hui un répertoire des serveurs et clients MCP, la plateforme communautaire mcp.so qui en répertorie 11 174 à ce jour (le nombre grimpe quotidiennement). Ce répertoire me rappelle le Craiglist des débuts de l’internet qui était un site répertoriant des petites annonces d’abord à San Francisco puis aux quatre coins des Etats-Unis. Craiglist a vite été marginalisé par des sites disposant d’une interface utilisateur plus travaillée: Ebay par exemple ou AirBnB. Là aussi, les chatbots ayant pignon sur rue ont d’avantage de chances de l’emporter: ils peuvent déjà intégrer le client MCP avec leur modèle, éliminant une étape pour l’utilisateur. Ce client MCP interne aura la capacité de “discuter” avec une multitude de serveurs MCP externes, donnant ainsi un vaste choix à l’utilisateur. C’est probablement la direction empruntée par Qwen avec sa rubrique “MCP bientôt”. Dans un premier temps, Qwen proposera ses propres serveurs MCP avec connexion et autorisation en quelques clics. Puis il s’ouvrira à des serveurs externes de manière à constituer une offre étoffée au travers d’un magasin de serveurs MCP. On peut s’attendre à ce que les autres grands modèles de langage emboitent le pas à Qwen et créent leur propre magasin. A la différence de l’ère de l’iPhone et de l’App Store, la concurrence est nettement plus ouverte. Cependant les chatbots les plus réputés auront d’avantage de chances de concentrer l’offre de serveurs MCP. Quels sont-ils aujourd’hui:

Aussi, même si Qwen est précurseur et qu’Anthropic a créé le protocole, il n’y a que trois candidats sérieux aujourd’hui pouvant créer un magasin à succès: Meta, Google et OpenAI. Cependant la compétition est ouverte: si un modèle comme Grok ou DeepSeek deviennent meilleurs, les abonnés peuvent changer de fournisseur. OpenAI a commencé l’intégration MCP en fournissant des SDK (kit de développement logiciel). Google DeepMind l’a promis pour bientôt. Enfin il n’y a pas de nouvelle de ce côté concernant Meta. Dans ce contexte, OpenAI pourrait bien être le premier à proposer un catalogue étoffé de serveurs et clients MCP, renforçant ainsi son avantage concurrentiel. Gemini ne sera pas loin derrière, pouvant compter sur sa puissance de distribution (silencieuse certes, mais réelle). Un élément important renforce cette dynamique: les données. En effet, l’orchestrateur du protocole, l’hôte décide comment les données du modèle et de l’application cible sont partagées ou isolées. Or les données peuvent être particulièrement sensibles (mails, codes, réservations, etc.). Les utilisateurs n’accepteront de confier leurs données qu’à des institutions de renom, ce qui limitera la concurrence.

Un nouvel App Store…d’OpenAI ?

Il reste à voir si le modèle économique de l’App Store s’appliquera à l’IA. Il peut être tentant pour les modèles de langage de pointe de vouloir reproduire un passé si juteux. Apple prélève en effet 30 % du chiffre d’affaires numérique de chaque application, se comportant en parfait despote. Le Play Store de Google suit discrètement avec un tarif similaire. Les magasins d’applications sont des machines à cash pour Apple et Google (près de 75 % de marge brute pour le premier). Cependant, il est probable que les développeurs ne se laisseront pas enfermer dans un modèle de ce type pour au moins deux raisons:

après une phase d’apathie qui a duré dix ans, les développeurs ont commencé à lutter contre le duopole: plusieurs ont monté la révolte, citons Spotify à partir de 2019, Basecamp, Epic Games et Match à partir de 2020; certains ont simplement interdits les transactions au travers de l’App Store pour éviter les 30 % (Netflix, Amazon Kindle, Spotify, Fortnite). Ces révoltes ont conduit à des procès, voire des actions des régulateurs (Europe, Corée du sud). Les développeurs n’ont pas l’intention de se laisser enfermer une deuxième fois et feront tout pour éviter d’être esclaves de la distribution. L’esclavage d’un modèle d’IA serait encore pire car les utilisateurs perdraient le contact avec les applications, les agents se chargeant du travail. La réplique simple et efficace pour les applications sera de n’exposer qu’une partie de leurs outils et ressources dans les serveurs MCP mis à disposition dans le public. Ils garderont ainsi jalousement la substantifique moëlle de leur offre et se serviront du serveur MCP public pour attirer le client.

A la différence d’iOS et Android, Les modèles de langage sont largement des commodités. Chacun (OpenAI, Meta, Google, xAI, etc.) essaie d’avoir le modèle le plus puissant, mais l’avantage tourne vite court. Dès lors, il y a plus de chance que le point de différenciation se situe au niveau du serveur MCP, l’intégration ayant lieu au niveau du serveur et de l’application de bout de chaine. Cela est cohérent avec la fameuse théorie de l’intégration et de la modularité de Clayton Christensen qui postule:

Le point d’intégration est l’endroit de la chaîne de valeur où l’innovation est la plus nécessaire et où l’intégration crée le plus de différenciation, se déplaçant au fil du temps à mesure que les autres éléments deviennent “suffisamment bons.

Au lieu d’être prisonnière d’un système d’exploitation ou en l’occurrence d’un modèle, l’innovation peut se déchaîner au niveau de l’application et de son serveur MCP. Le modèle, l’hôte, le client MCP et le magasin de serveurs MCP sont eux banalisés. Les développeurs ont l’opportunité de créer une application et de la faire distribuer sans craindre la taxe de 30%. Cette taxe est d’autant plus anti-compétitive que les magasins d’applications type App Store ne l’appliquent pas à leurs applications développées en interne (Apple Music, Apple TV + par exemple). Aujourd’hui seules les applications à gros succès type Netflix peuvent obliger leurs abonnés à souscrire en dehors de l’App Store et ainsi préserver l’intégralité de leurs marges. Ce scénario ne se reproduira pas sur l’IA, trop de modèles étant en concurrence. Il ressemblera d’avantage à ce qui se produit aujourd’hui pour les applications d’entreprises (sociétés SAAS), dont les souscriptions sont opérées sur le PC. Cela a permis un écosystème de sociétés SAAS innovantes très bien valorisées en bourse:

Entreprises/grand public

N’étant pas distribuées par un magasin d’applications, ces sociétés ont dû investir massivement dans le marketing et la vente directe. Les réussites sont spectaculaires et nombreuses. Côté applications numériques grand public, à part Netflix et Spotify qui interdisent la souscription par l’App Store, les capitalisations boursières sont plus modestes, être materné par Apple a un coût:

Les applications d’entreprise vont être les premières à essayer de prolonger leur avantage concurrentiel avec les clients et serveurs MCP. Elles bénéficient de la notoriété acquise par un gros investissement marketing et vont capitaliser sur cet avantage pour proposer leurs propres serveurs/ clients MCP ou aider à les construire (exemple des bases de données). L’argument de vente sera très simple: économisez des frais de personnel grâce aux agents branchés par le protocole MCP, que ces agents soient connectés à ChatGPT, Claude ou même des petits modèles tournant sur un PC. L’économie de ressources humaines étant considérable, la facturation sera fortement rehaussée. L’IA sera pour ces sociétés une innovation de continuité. Le modèle économique SAAS est déjà le lego, le protocole MCP en est la continuité Il y a trois opérateurs cloud, ce qui suffit à créer une bonne concurrence, il y a quatre ou cinq modèles IA de pointe et de nombreux autres moins sophistiqués, ce qui suffira à maintenir cette concurrence, voire à l’accentuer.

Il en va autrement des applications grand public. Le recours à une distribution externe centralisée est quasiment inéluctable pour toucher un large public. Dans le monde des apps, la distribution se fait par Apple, Google ou Meta. Elle sera probablement plus partagée pour les serveurs et clients MCP, les modèles comme Grok et OpenAI s’ajoutant à la partie. Il n’en reste pas moins que les applications auront besoin non pas des API des modèles de pointe ou de leurs hôtes mais des créateurs de ces modèles de pointe pour leur distribution c’est à dire Open AI, xAI, Google, Microsoft, Meta, Anthropic, etc. Le marché des applications ne dépendra pas d’un duopole iOS/Android, il sera plus équilibré, le co-branding devrait prévaloir. ChatGPT ne pourra lancer un morceau de musique sans que l’utilisateur ait intériorisé qu’il vient d’Amazon Music par exemple. Des applications innovantes pour faire de la recherche approfondie, se connecter à des cartes géographiques, extraire des données, gérer ses messages, etc. auront plus de chances de percer n’étant pas soumises à la taxe de 30%. Pour avoir une idée de la créativité actuelle, il faut se rendre sur le site de référence mcp.so. En fait, la création de serveurs et clients MCP présente une double opportunité pour les applications grand public:

De nouvelles applications grand public vont pouvoir émerger et pour certaines atteindre des valeurs considérables, elles seront aidées plus que dominées par les grands chatbots;

les applications actuelles pourront se détacher du duopole iOS/Android et ainsi augmenter significativement leur valeur.

Le parallèle avec Linux

L’industrie du cloud n’aurait pu se développer comme elle l’a fait sans Linux. C’est grâce au noyau Linux qu’ont été développés en open source les gestionnaires de machines virtuelles (Xen et KVM), les conteneurs (Kubernetes), les modules de sécurité (SELinux, eBPF…), enfin les pilotes et tout l’écosystème.

L’innovation communautaire gratuite a fourni les principales briques du cloud qui sont devenues un standard adopté par AWS, Azure, Google cloud, les plateformes logicielles comme Salesforce et les applications SAAS (Box, Service Now, Adobe, etc.) Sans Linux, le cloud existerait peut-être mais serait entre les mains de groupes comme IBM, HP et Windows. Les économies d’échelle seraient bien inférieures et la valeur captée par ces systèmes propriétaires. Linux a littéralement détruit ces systèmes propriétaires et a rendu possible une industrie d’une valeur de plusieurs trillions de dollars.

Le protocole MCP est, comme Linux, open source, communautaire, standard, gratuit. Il constitue lui aussi une plateforme de développement. Il s’oppose à la logique propriétaire d’OpenAI comme Linux s’opposait à celle de Windows. Le protocole MCP gère principalement des ressources (données) et des outils (actions). Plus les données sont complexes, plus il y aura volonté d’automatiser pour gagner en productivité, ce qui permettra de traiter d’avantage de données et ainsi d’améliorer la qualité du service:

Le protocole MCP est dans la logique du cloud et il le renforce. Les enjeux en terme d’économie de personnel et de qualité de service deviennent majeurs, rendant les sociétés SAAS (software as a service) de plus en plus incontournables.

Revenons à Qwen: la Chine a de petits moyens en terme de puces intelligentes, surtout qu’elle est privée des produits Nvidia, TSMC et ASML. Elle dispose cependant de 50% des ingénieurs IA dans le monde (source Jensen Huang). Ce contexte la dispose à exploiter au maximum l’open source et à inonder la planète de solutions bon marché…à l’échelle. La Chine n’a pas inventé le protocole MCP mais elle pourrait bien en être la première bénéficiaire. Il y a le précédent des batteries au lithium…Cela pose la question de la pertinence de la politique gouvernementale américaine sur les semi-conducteurs. Comme l’écrivait Frédéric Bastiat au XIX ème siècle, il y a ce qu’on voit (les restrictions en l’occurrence) et ce qu’on ne voit pas (les incitations à développer soi-même).

Bonne fin de semaine,

Hervé